不输ChatGPT 国产AI大模型开测:为中文优化、支持国产CPU训练

ChatGPT今天升级到GPT-4模型,AI能力更加强大。中国在这方面也在迎头赶上。有国歌的ChatGPT国内版已经出版。现在,清华大学教授唐杰宣布,由该校人工智能成果转化而来的ChatGLM已经开始内部测试。

据介绍,具有初始问答和对话功能的1000亿中英语言模型对话机器人ChatGLM(alpha beta: QAGLM)已经针对中文进行进行了优化,并开放邀请系统进行内测,未来将逐步扩大内测范围。

同时,继开源GLM-13000亿基座/[K0/],正式开放最新双语对话GLM 模型: ChatGLM- 6B,并结合量化技术,让用户享受消费级对话。

同时,继开源GLM-13000亿基座/[K0/],正式开放最新双语对话GLM 模型: ChatGLM- 6B,并结合量化技术,让用户享受消费级对话。经过中英文约1T标识符的双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术,62亿参数ChatGLM-6B不到1000亿模型,却大大降低了用户部署的门槛,已经能够生成相当符合人类喜好的答案。

ChatGLM参考了ChatGPT的设计思想,将代码预训练注入到1000亿基座/[k0/]GLM- 130b1中,通过有监督的微调对齐人类意图。

当前版本模型的ChatGLM能力提升主要来自于独有的1000亿基座模型 GLM-130B。它不同于BERT,GPT-3和T5,是多目标函数模型的自回归预训练。

2022年8月,我们向科研和行业开放了1300亿参数的双语密集模型 GLM-130B1,具有一些独特的优势:

双语:支持中文和英文。

准确率高(英文):在已公布的英文自然语言列表上,优于GPT-3 175B(API: davinci,基座模型),OPT-175B,BLOOM-176B。

高准确率(中文):在7个零样本线索数据集和5个零样本FewCLUE数据集上明显优于ERNIE TITAN 3.0 260B和袁1.0-245B。

快速推理:第一个实现INT4的量子化,用4卡3090或8卡2080Ti服务器进行支持快速且基本无损的推理。

可再现性:所有结果(超过30个任务)都可以通过我们的开源代码和模型参数再现。

跨平台:支持在国产广海DCU、华为910和美国神威处理器、英伟达芯片上训练推理进行。

2022年11月,斯坦福大学中心模型对全球30所主流大学模型/[k1/]进行综合评价,GLM-130B为亚洲唯一模型。

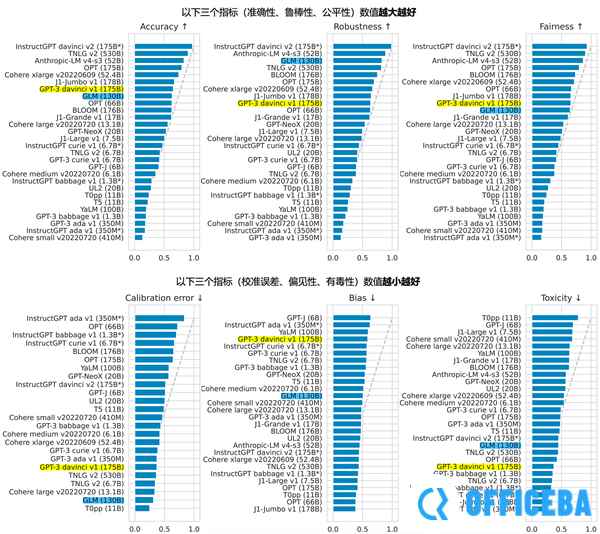

评测报告对比了OpenAI、Google Brain、微软、Nvidia、脸书,结果显示/[K2/] 130b在准确率和恶意度上接近或等于/[K4/] 3 175b(达芬奇),鲁棒性和标定误差在所有十亿级尺度上均为基座。

图一。斯坦福大学基金会模型中心对全球30所大学模型的评估结果(2022年11月)

图一。斯坦福大学基金会模型中心对全球30所大学模型的评估结果(2022年11月)以上就是小编给大家带来的不输ChatGPT 国产AI大模型开测:为中文优化、支持国产CPU训练的全部内容了,如果对您有帮助,可以关注officeba网站了解后续资讯。

相关文章

- 不输ChatGPT 国产AI大模型开测:为中文优化、支持国产CPU训练 2025-02-24

同类最新